A lire sur: http://www.finyear.com/La-triple-rupture-des-Big-Data_a25508.html

Les Big Data marquent une triple rupture dans l'évolution des systèmes d'information : explosion du nombre de données disponibles, variété croissante et renouvellement permanent de ces données. Leur traitement demande bien plus que de la puissance de calcul. Il exige de rompre avec le raisonnement cartésien, pour retrouver la face dite non-scientifique de la pensée humaine : le raisonnement inductif.

Revenons brièvement sur la mutation en cours, qui est en train de révolutionner le secteur des technologies de l’information.

des technologies de l’information.

Une révolution industrielle du traitement des données

En 2013 ce sont près de 6 zettaoctets d’information (mille milliards de milliards d’octets) qui seront rendus disponibles sur le réseau mondial. La quantité double tous les deux ans, et l’ouverture progressive des données des institutions et des entreprises dans le cadre de l’Open Data renforce encore ce phénomène. L’émergence des technologies du Big Data répond d’abord à cette croissance exponentielle des données disponibles.

Un système Big Data présente deux volets étroitement liés : le stockage et l’analyse. L’analyse s’appuie sur un stockage en facilitant l’accès, le stockage s’appuie sur une analyse en réduisant le volume. Les solutions analytiques répondant réellement à cette problématique ont deux caractéristiques : l’induction et la célérité.

Il ne s’agit pas seulement de puissance de calcul. Le monde du Big Data implique en effet pour les acteurs une véritable révolution culturelle. Il leur faut en quelque sorte accepter de lâcher prise, en acceptant de travailler avec des données parcellaires, disponibles, rapidement accessibles : cela implique en retour de ne pas chercher à les conserver, de les considérer comme des produits consommables et même périssables. Cela amène enfin à les transformer pour un nouvel usage.

On peut parler d’une révolution industrielle, car en bousculant les habitudes instituées au cours des quelques décennies d’existence de l’informatique, les nouvelles façons de faire s’inscrivent dans un mouvement de création-destruction particulièrement intense. À l’évidence, la capacité à traiter rapidement de vastes masses de données parfois disparates, pour en extraire des informations utiles, est un gisement de valeur ajoutée. On assiste aujourd’hui à la

naissance d’un secteur, et cela va de pair avec une déstabilisation des

acteurs technologiques plus anciens : certains, comme IBM, se

reconvertissent avec succès, d’autres peinent à prendre le train en

marche, faute de saisir exactement ce qui est en jeu, ou d’accepter de

se réinventer.

utiles, est un gisement de valeur ajoutée. On assiste aujourd’hui à la

naissance d’un secteur, et cela va de pair avec une déstabilisation des

acteurs technologiques plus anciens : certains, comme IBM, se

reconvertissent avec succès, d’autres peinent à prendre le train en

marche, faute de saisir exactement ce qui est en jeu, ou d’accepter de

se réinventer.

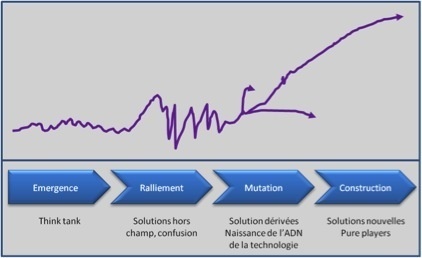

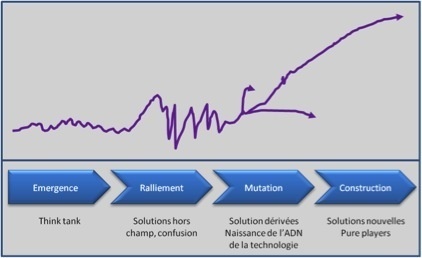

On assiste ainsi en ce moment à une séquence souvent répétée dans le domaine de l’innovation. La diffusion d’une nouvelle notion reprend généralement les mêmes étapes. La phase d’émergence, marquée comme souvent par le sceau du Gartner Group et du MIT, est révolue. Actuellement nous vivons la phase de ralliement, qui est génératrice d’une certaine confusion. Chaque acteur technologique cherche à se glisser dans le flux. Que sa solution soit big data ou non, il s’arrange avec les termes, il monte des compromis pour ne pas être exclu du mouvement. Viendra ensuite la phase de mutation, qui verra naître des solutions technologiques dérivées de solutions existantes mais disposant d’une vraie valeur ajoutée par rapport à la notion nouvelle, intégrant son « ADN ». Certains acteurs en pointe y travaillent déjà, certaines de ces solutions commencent à poindre. On verra enfin une phase de construction, avec l’apparition de pure players mettant sur le marché des solutions et des services que nous n’imaginons pas aujourd’hui.

Une révolution industrielle du traitement des données

En 2013 ce sont près de 6 zettaoctets d’information (mille milliards de milliards d’octets) qui seront rendus disponibles sur le réseau mondial. La quantité double tous les deux ans, et l’ouverture progressive des données des institutions et des entreprises dans le cadre de l’Open Data renforce encore ce phénomène. L’émergence des technologies du Big Data répond d’abord à cette croissance exponentielle des données disponibles.

Un système Big Data présente deux volets étroitement liés : le stockage et l’analyse. L’analyse s’appuie sur un stockage en facilitant l’accès, le stockage s’appuie sur une analyse en réduisant le volume. Les solutions analytiques répondant réellement à cette problématique ont deux caractéristiques : l’induction et la célérité.

Il ne s’agit pas seulement de puissance de calcul. Le monde du Big Data implique en effet pour les acteurs une véritable révolution culturelle. Il leur faut en quelque sorte accepter de lâcher prise, en acceptant de travailler avec des données parcellaires, disponibles, rapidement accessibles : cela implique en retour de ne pas chercher à les conserver, de les considérer comme des produits consommables et même périssables. Cela amène enfin à les transformer pour un nouvel usage.

On peut parler d’une révolution industrielle, car en bousculant les habitudes instituées au cours des quelques décennies d’existence de l’informatique, les nouvelles façons de faire s’inscrivent dans un mouvement de création-destruction particulièrement intense. À l’évidence, la capacité à traiter rapidement de vastes masses de données parfois disparates, pour en extraire des informations

On assiste ainsi en ce moment à une séquence souvent répétée dans le domaine de l’innovation. La diffusion d’une nouvelle notion reprend généralement les mêmes étapes. La phase d’émergence, marquée comme souvent par le sceau du Gartner Group et du MIT, est révolue. Actuellement nous vivons la phase de ralliement, qui est génératrice d’une certaine confusion. Chaque acteur technologique cherche à se glisser dans le flux. Que sa solution soit big data ou non, il s’arrange avec les termes, il monte des compromis pour ne pas être exclu du mouvement. Viendra ensuite la phase de mutation, qui verra naître des solutions technologiques dérivées de solutions existantes mais disposant d’une vraie valeur ajoutée par rapport à la notion nouvelle, intégrant son « ADN ». Certains acteurs en pointe y travaillent déjà, certaines de ces solutions commencent à poindre. On verra enfin une phase de construction, avec l’apparition de pure players mettant sur le marché des solutions et des services que nous n’imaginons pas aujourd’hui.

Une industrie est née. De nombreuses sociétés vont naître pour

extraire et transformer ces données… et naturellement en produire

d’autres. Penchons-nous à présent d’un peu plus près sur les ruptures

technologiques qui sont au cœur de cette révolution industrielle. Toutes

ont en commun de privilégier un traitement des données en temps réel :

c’est pourquoi la notion de célérité est au cœur de ces technologies.

Mais ce n’est pas tout. Pour la plupart, elles mettent en jeu un mode

raisonnement très ancien, mais longtemps resté à l’écart de la pensée

scientifique et technique, et dont l’introduction est au cœur de la

rupture constituée par les Big Data : la pensée inductive.

À rebours de la pensée déductive

L’analyse des immenses masses de données du Big Data se fait principalement par la mise en évidence de corrélations. Cette notion issue de la biologie est utilisée en économie depuis longtemps, mais on considère généralement que sur le plan scientifique elle n’a qu’une valeur descriptive : elle identifie une liaison entre deux variables, mais ne l’explique pas. Elle peut néanmoins être utilisée pour vérifier une hypothèse.

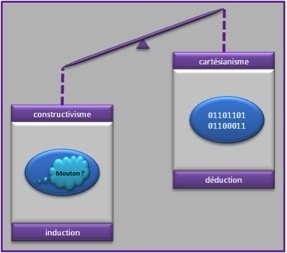

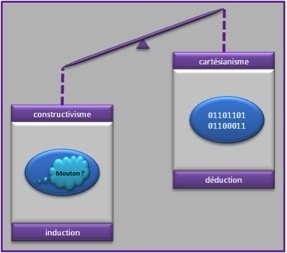

C’est précisément sur ce point que les Big Data s’écartent de la connaissance scientifique « traditionnelle », telle que l’a formalisée Karl Popper. Celle-ci procède principalement par déduction : d’une hypothèse, on déduit, logiquement, une conséquence, qu’on essaie ensuite de mettre à l’épreuve pour la vérifier. Rien de tel avec les Big Data, qui procèdent par induction.

De quoi s’agit-il ? L’induction, contrairement à la déduction, est un mécanisme utilisé par le cerveau humain presque à chaque instant. En effet, bien que la déduction soit jugée plus propre, plus scientifique, elle n’occupe qu’une partie du temps de traitement de notre cerveau. Elle s’applique particulièrement bien lorsque l’on analyse une situation hors de son contexte.

Par exemple, vouloir user d’une logique déductive pour traverser une rue imposerait de mesurer les vitesses des véhicules, de les placer dans l’espace avant de décider, à l’aide d’un système d’équations, du bon moment pour traverser. Inutile de souligner le caractère rédhibitoire de la lenteur qu’induirait cette analyse en n’utilisant que nos seuls sens et notre capacité cognitive…

En fait, notre cerveau appréhende la scène situationnelle de façon globale et la traite par induction. Pour ce faire, il généralise des principes observés lors de situations similaires nous impliquant ou impliquant ceux que nous observons (d’autres traversées de rues, en tous temps, avec ou sans lumière, sol mouillé ou non…). Notre cerveau est capable d’intégrer un nombre colossal de paramètres en une fraction de seconde et de projeter le fruit de ses inductions sur la scène courante.

Et c’est bien ce que requiert le traitement de données dans le cadre des Big Data : rechercher instantanément des informations essentielles, les traiter dans leur globalité sans a priori, reproduire des mécanismes efficaces déjà observés, produire de nouvelles informations directement utilisables dans la situation courante. Chris Anderson, alors rédacteur en chef de Wired, est l’un des premiers à avoir pointé les conséquences de cette méthode, dans un article fameux http://www.wired.com/science/discoveries/magazine/16-07/pb_theory paru en 2008. La connaissance issue des Big Data, explique-t-il, sera produite à partir de statistiques « agnostiques », et cette absence de point de vue est même l’une des conditions de leur réussite : les chiffres parlent pour eux-mêmes, en quelque sorte.

Par rapport à toute la tradition scientifique occidentale, issue de Descartes, cette approche est renversante, et l’on conçoit aisément que des esprits scientifiques, formés à la pensée déductive, ne soient pas très à l’aise avec elle. Plus largement, en dehors des spécialistes de l’épistémologie constructiviste (le constructivisme, en épistémologie, est une approche de la connaissance reposant sur l’idée que notre image de la réalité, ou les notions structurant cette image, sont le produit de l’esprit humain en interaction avec cette réalité, et non le reflet exact de la réalité elle-même) on connaît mal les principes d’induction et d’abduction. L’éducation, dans les sociétés développées, s’est polarisée autour des principes hypothético-déductifs érigés en « pensée unique ». Pourtant un enfant, avant l’âge de sept ans, fonctionne dans un mode inductif et ce n’est que vers cet « âge de raison » qu’il découvre la logique déductive et le raisonnement démontré. Mais c’est un fait : l’élève n’entendra vraisemblablement pas parler d’induction dans son cursus scolaire. Pourtant, la logique inductive reste celle de notre vie courante, de nos actes quotidiens.

À rebours de la pensée déductive

L’analyse des immenses masses de données du Big Data se fait principalement par la mise en évidence de corrélations. Cette notion issue de la biologie est utilisée en économie depuis longtemps, mais on considère généralement que sur le plan scientifique elle n’a qu’une valeur descriptive : elle identifie une liaison entre deux variables, mais ne l’explique pas. Elle peut néanmoins être utilisée pour vérifier une hypothèse.

C’est précisément sur ce point que les Big Data s’écartent de la connaissance scientifique « traditionnelle », telle que l’a formalisée Karl Popper. Celle-ci procède principalement par déduction : d’une hypothèse, on déduit, logiquement, une conséquence, qu’on essaie ensuite de mettre à l’épreuve pour la vérifier. Rien de tel avec les Big Data, qui procèdent par induction.

De quoi s’agit-il ? L’induction, contrairement à la déduction, est un mécanisme utilisé par le cerveau humain presque à chaque instant. En effet, bien que la déduction soit jugée plus propre, plus scientifique, elle n’occupe qu’une partie du temps de traitement de notre cerveau. Elle s’applique particulièrement bien lorsque l’on analyse une situation hors de son contexte.

Par exemple, vouloir user d’une logique déductive pour traverser une rue imposerait de mesurer les vitesses des véhicules, de les placer dans l’espace avant de décider, à l’aide d’un système d’équations, du bon moment pour traverser. Inutile de souligner le caractère rédhibitoire de la lenteur qu’induirait cette analyse en n’utilisant que nos seuls sens et notre capacité cognitive…

En fait, notre cerveau appréhende la scène situationnelle de façon globale et la traite par induction. Pour ce faire, il généralise des principes observés lors de situations similaires nous impliquant ou impliquant ceux que nous observons (d’autres traversées de rues, en tous temps, avec ou sans lumière, sol mouillé ou non…). Notre cerveau est capable d’intégrer un nombre colossal de paramètres en une fraction de seconde et de projeter le fruit de ses inductions sur la scène courante.

Et c’est bien ce que requiert le traitement de données dans le cadre des Big Data : rechercher instantanément des informations essentielles, les traiter dans leur globalité sans a priori, reproduire des mécanismes efficaces déjà observés, produire de nouvelles informations directement utilisables dans la situation courante. Chris Anderson, alors rédacteur en chef de Wired, est l’un des premiers à avoir pointé les conséquences de cette méthode, dans un article fameux http://www.wired.com/science/discoveries/magazine/16-07/pb_theory paru en 2008. La connaissance issue des Big Data, explique-t-il, sera produite à partir de statistiques « agnostiques », et cette absence de point de vue est même l’une des conditions de leur réussite : les chiffres parlent pour eux-mêmes, en quelque sorte.

Par rapport à toute la tradition scientifique occidentale, issue de Descartes, cette approche est renversante, et l’on conçoit aisément que des esprits scientifiques, formés à la pensée déductive, ne soient pas très à l’aise avec elle. Plus largement, en dehors des spécialistes de l’épistémologie constructiviste (le constructivisme, en épistémologie, est une approche de la connaissance reposant sur l’idée que notre image de la réalité, ou les notions structurant cette image, sont le produit de l’esprit humain en interaction avec cette réalité, et non le reflet exact de la réalité elle-même) on connaît mal les principes d’induction et d’abduction. L’éducation, dans les sociétés développées, s’est polarisée autour des principes hypothético-déductifs érigés en « pensée unique ». Pourtant un enfant, avant l’âge de sept ans, fonctionne dans un mode inductif et ce n’est que vers cet « âge de raison » qu’il découvre la logique déductive et le raisonnement démontré. Mais c’est un fait : l’élève n’entendra vraisemblablement pas parler d’induction dans son cursus scolaire. Pourtant, la logique inductive reste celle de notre vie courante, de nos actes quotidiens.

L’induction nous permet de généraliser un phénomène observé, même

s’il ne l’est qu’une seule fois. Cette logique, pourtant

fondamentalement humaine, reste étrangère à des ingénieurs et

scientifiques rodés à l’épistémologie cartésienne. Cela explique un

certain nombre de confusions, qui obscurcissent la compréhension des Big

Data. Certains voient dans l’induction une forme de statistique et

confondent la recherche de singularité avec une segmentation plus fine

d’éléments obtenue statistiquement. D’aucuns parlent même d’intuition

pour désigner l’induction.

Dans tous ces cas, la confusion est issue d’une volonté de comparer différents principes sur des domaines identiques. En fait il y a un domaine où la déduction excelle et un domaine où l’induction est de mise. Chercher à faire de l’induction là où la déduction est efficace et pertinente est une ineptie… mais l’inverse est tout aussi vrai. Les deux outils ne sont pas comparables, et en un sens ils ne sont pas concurrents. La sagesse est d’employer le bon outil dans la bonne circonstance.

Cette dualité se retrouve dans l’approche temporelle de l’analyse. La déduction, la statistique ou la probabilité peuvent se nourrir en une fois de plusieurs années de données pour établir une « loi », c’est-à-dire un résultat répétable. L’induction est en revanche une technique continue, qui demande du temps. Elle fonctionne au fil de l’eau, elle va dégager des singularités, élargir leur assiette et mesurer l’efficacité de leur application.

Il n’y a pas d’unicité du raisonnement inductif. Le raisonnement dépend des inductions précédentes, des singularités détectées. Il n’est pas répétable. Là encore, on est loin des principes cartésiens. L’induction n’exige pas de disposer de paramètres complets et cohérents, car de toute façon notre cerveau ne les traitera que partiellement lui aussi, en se concentrant sur ce qu’il juge être l’essentiel de la situation. En contrepartie de cette célérité il y aura aussi production d’erreurs.

Les algorithmes inductifs

Depuis une petite dizaine d’années, les travaux sur les algorithmes inductifs se sont multipliés dans les universités. La forte croissance des réseaux sociaux a renforcé la demande pour ces algorithmes, qui sont au cœur des technologies « Big Data ».

Il faut savoir que lorsque l’informatique se saisit d’une notion, elle en crée généralement une forme qui lui est propre, et cette forme est souvent réductrice. Par exemple, au sens philosophique, l’ontologie est l’étude de l’être. En informatique l’ontologie n’est qu’un modèle de représentation de connaissances. De même, en philosophie l’induction est un mode de raisonnement constructiviste qui produit des orientations plausibles. En informatique, à quelques exceptions près, l’induction se résume à l’application à des graphes du principe de récurrence.

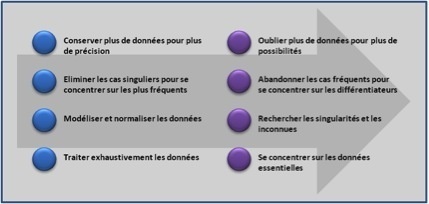

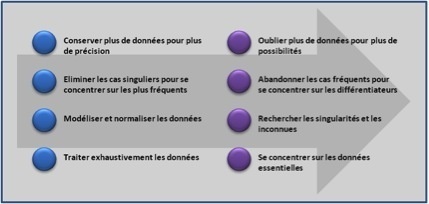

Pour un professionnel, traiter des données sur un mode inductif exige un changement de posture. Nombre de principes se retrouvent totalement inversés lorsque l’on passe d’un raisonnement déductif à un raisonnement inductif.

Par exemple : conserver plus de données pour plus de précision devient : oublier plus de données pour ouvrir plus de possibilités. Éliminer les cas singuliers pour se concentrer sur les plus fréquents devient : abandonner les cas fréquents pour se concentrer sur les différentiateurs. Modéliser et normaliser les données devient : rechercher les singularités et les inconnues. Traiter exhaustivement les données devient : se concentrer sur les données essentielles.

Dans tous ces cas, la confusion est issue d’une volonté de comparer différents principes sur des domaines identiques. En fait il y a un domaine où la déduction excelle et un domaine où l’induction est de mise. Chercher à faire de l’induction là où la déduction est efficace et pertinente est une ineptie… mais l’inverse est tout aussi vrai. Les deux outils ne sont pas comparables, et en un sens ils ne sont pas concurrents. La sagesse est d’employer le bon outil dans la bonne circonstance.

Cette dualité se retrouve dans l’approche temporelle de l’analyse. La déduction, la statistique ou la probabilité peuvent se nourrir en une fois de plusieurs années de données pour établir une « loi », c’est-à-dire un résultat répétable. L’induction est en revanche une technique continue, qui demande du temps. Elle fonctionne au fil de l’eau, elle va dégager des singularités, élargir leur assiette et mesurer l’efficacité de leur application.

Il n’y a pas d’unicité du raisonnement inductif. Le raisonnement dépend des inductions précédentes, des singularités détectées. Il n’est pas répétable. Là encore, on est loin des principes cartésiens. L’induction n’exige pas de disposer de paramètres complets et cohérents, car de toute façon notre cerveau ne les traitera que partiellement lui aussi, en se concentrant sur ce qu’il juge être l’essentiel de la situation. En contrepartie de cette célérité il y aura aussi production d’erreurs.

Les algorithmes inductifs

Depuis une petite dizaine d’années, les travaux sur les algorithmes inductifs se sont multipliés dans les universités. La forte croissance des réseaux sociaux a renforcé la demande pour ces algorithmes, qui sont au cœur des technologies « Big Data ».

Il faut savoir que lorsque l’informatique se saisit d’une notion, elle en crée généralement une forme qui lui est propre, et cette forme est souvent réductrice. Par exemple, au sens philosophique, l’ontologie est l’étude de l’être. En informatique l’ontologie n’est qu’un modèle de représentation de connaissances. De même, en philosophie l’induction est un mode de raisonnement constructiviste qui produit des orientations plausibles. En informatique, à quelques exceptions près, l’induction se résume à l’application à des graphes du principe de récurrence.

Pour un professionnel, traiter des données sur un mode inductif exige un changement de posture. Nombre de principes se retrouvent totalement inversés lorsque l’on passe d’un raisonnement déductif à un raisonnement inductif.

Par exemple : conserver plus de données pour plus de précision devient : oublier plus de données pour ouvrir plus de possibilités. Éliminer les cas singuliers pour se concentrer sur les plus fréquents devient : abandonner les cas fréquents pour se concentrer sur les différentiateurs. Modéliser et normaliser les données devient : rechercher les singularités et les inconnues. Traiter exhaustivement les données devient : se concentrer sur les données essentielles.

Ce serait une erreur, lors de la conception d’un algorithme

inductif, de vouloir appliquer des principes relevant de la logique

déductive. C’est l’une des grandes difficultés des Big Data : il faut

savoir choisir. Soit on raisonne dans le cadre d’une approche

hypothético-déductive, soit on opte résolument pour une approche

inductive.

De cette deuxième option découlent plusieurs conséquences. Par exemple, si, en raisonnement déductif, il y a toujours une fin au traitement, en raisonnement inductif il n’en existe généralement pas. Les résultats des inférences sont susceptibles de modifier les inférences déjà réalisées. Il est ainsi possible de poursuivre les raisonnements à l’infini. L’algorithme inductif doit alors être associé à une fonction de convergence (dite aussi fonction de récompense) qui mesure le bénéfice des nouvelles inférences et en limite ainsi le nombre.

Deuxième conséquence : à une problématique donnée il n’existe pas de solution inductive unique. La multiplicité des traitements possibles peut toutefois se réduire, car il est fréquent qu’un nombre réduit de traitements satisfasse à un objectif particulier, à une finalité particulière. Mais par voie de conséquence un algorithme inductif est rarement d’usage universel.

Un algorithme conçu dans le cadre d’une approche inductive aura enfin une dernière caractéristique marquante : s’il n’est pas destiné à vérifier une hypothèse déjà présente, il peut néanmoins être conçu en fonction d’une certaine finalité : ses « produits », c’est-à-dire les graphes qu’il permet d’élaborer à partir des données analysées, ont un usage, et la connaissance de cet usage par l’algorithme est une information précieuse pour mesurer sa propre efficacité. Elle servira notamment pour les calculs de plausibilité. Les meilleurs algorithmes inductifs sont donc évolutifs : ils « apprennent », affinant leurs façon de traiter les données en fonction de l’usage le plus pertinent qui pourra en être fait.

En temps réel

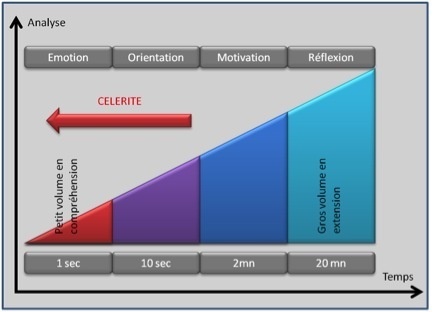

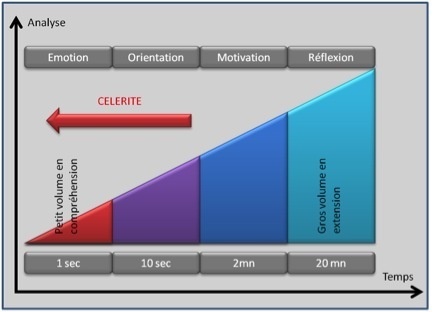

Cet apprentissage au fil du temps est inséparable de la deuxième grande caractéristique des Big Data : la célérité.

au fil du temps est inséparable de la deuxième grande caractéristique des Big Data : la célérité.

Dans la mesure où le risque d’erreur unitaire est acceptable pour l’utilisateur (individu ou organisation), il est souvent préférable de disposer d’une information correcte immédiatement, plutôt que de disposer d’une information complète et sûre, mais plus tardivement. Dans un monde où chaque milliseconde compte, où une vente se fera en ligne chez le concurrent simplement parce que le temps de réponse y est moins long, la dimension « temps réel » de l’information devient cruciale.

L’ordre de grandeur d’une plage de réflexion, pour un être humain confronté à une décision telle qu’un achat, est de l’ordre de la dizaine de minutes : cela laisse le temps aux systèmes décisionnels de brasser des informations et d’orienter une décision. Mais la vie du Net est venue modifier ces repères. En effet l’interaction entre l’internaute et son environnement glisse progressivement de la sphère de la cognition plus lente vers la sphère de la motivation voire celle de l’émotion à forte célérité. Ici les ordres de grandeurs des systèmes en interaction avec l’internaute sont bien souvent de l’ordre de la seconde, voire moins.

Sur le plan de la psychosociologie, le phénomène est encore démultiplié par la vitesse de propagation de l’information au sein des communautés connectées. En quelques centaines de secondes, ce sont des millions de personnes qui peuvent être informées d’une façon susceptible de modifier en profondeur leur comportement. Disposer de l’information ne suffit plus : il faut aussi anticiper ses impacts sociaux.

Poursuivre avec les technologies existantes conduirait irrémédiablement à concevoir des réseaux d’ordinateurs massivement parallèles : gigantisme et complexité de mise en œuvre en limiteraient assurément l’usage.

Les technologies du Big Data répondent précisément à cet enjeu : traiter bien plus rapidement une quantité grandissante d’informations. Là encore, cela suppose de se tourner vers une approche constructiviste.

L’exemple, à nouveau, se trouve sous nos yeux, au sein même de nos sociétés. Personne ne cherche à maîtriser parfaitement son environnement, mais chacun a conscience d’y apporter une contribution. L’équation liant la célérité et la contribution est déterminante dans la vie sociale. Apporter peu, très vite, est peu déterminant ; apporter plus, mais moins vite, c’est prendre le risque d’être devancé. Toute société vit dans cet équilibre de la compétition et de la collaboration, et c’est dans le même esprit que sont développés les algorithmes qui permettent la célérité.

Les algorithmes de célérité

Il est toujours possible d’optimiser les temps de traitement des algorithmes, mais lorsque le volume d’information croît et que, comme nous l’avons vu, les critères liés à son accès sont flous, la vitesse de traitement sera mathématiquement limitée.

Pour concevoir des algorithmes inductifs de célérité, il est nécessaire de penser autrement. L’algorithme devra être contributif et anticipatif. Pour cela l’application informatique devra s’inscrire dans un flux continu d’information et regrouper une collection d’agents chargés de transformer au plus tôt cette information en connaissance exploitable pour les instants suivants.

Cela ne va pas sans conséquence. Par exemple, en informatique décisionnelle il est d’usage de conserver l’information brute afin de conduire des traitements ultérieurs non encore déterminés. En algorithmie inductive de célérité, on préférera transformer l’information d’une forme « en extension » (exemple : conservation de tous les tickets de caisse de monsieur Dupont) vers une forme « en compréhension » (exemple : monsieur Dupont achète un pain tous les lundi et quelquefois un gâteau) plus maniable et moins volumineuse.

De cette deuxième option découlent plusieurs conséquences. Par exemple, si, en raisonnement déductif, il y a toujours une fin au traitement, en raisonnement inductif il n’en existe généralement pas. Les résultats des inférences sont susceptibles de modifier les inférences déjà réalisées. Il est ainsi possible de poursuivre les raisonnements à l’infini. L’algorithme inductif doit alors être associé à une fonction de convergence (dite aussi fonction de récompense) qui mesure le bénéfice des nouvelles inférences et en limite ainsi le nombre.

Deuxième conséquence : à une problématique donnée il n’existe pas de solution inductive unique. La multiplicité des traitements possibles peut toutefois se réduire, car il est fréquent qu’un nombre réduit de traitements satisfasse à un objectif particulier, à une finalité particulière. Mais par voie de conséquence un algorithme inductif est rarement d’usage universel.

Un algorithme conçu dans le cadre d’une approche inductive aura enfin une dernière caractéristique marquante : s’il n’est pas destiné à vérifier une hypothèse déjà présente, il peut néanmoins être conçu en fonction d’une certaine finalité : ses « produits », c’est-à-dire les graphes qu’il permet d’élaborer à partir des données analysées, ont un usage, et la connaissance de cet usage par l’algorithme est une information précieuse pour mesurer sa propre efficacité. Elle servira notamment pour les calculs de plausibilité. Les meilleurs algorithmes inductifs sont donc évolutifs : ils « apprennent », affinant leurs façon de traiter les données en fonction de l’usage le plus pertinent qui pourra en être fait.

En temps réel

Cet apprentissage

Dans la mesure où le risque d’erreur unitaire est acceptable pour l’utilisateur (individu ou organisation), il est souvent préférable de disposer d’une information correcte immédiatement, plutôt que de disposer d’une information complète et sûre, mais plus tardivement. Dans un monde où chaque milliseconde compte, où une vente se fera en ligne chez le concurrent simplement parce que le temps de réponse y est moins long, la dimension « temps réel » de l’information devient cruciale.

L’ordre de grandeur d’une plage de réflexion, pour un être humain confronté à une décision telle qu’un achat, est de l’ordre de la dizaine de minutes : cela laisse le temps aux systèmes décisionnels de brasser des informations et d’orienter une décision. Mais la vie du Net est venue modifier ces repères. En effet l’interaction entre l’internaute et son environnement glisse progressivement de la sphère de la cognition plus lente vers la sphère de la motivation voire celle de l’émotion à forte célérité. Ici les ordres de grandeurs des systèmes en interaction avec l’internaute sont bien souvent de l’ordre de la seconde, voire moins.

Sur le plan de la psychosociologie, le phénomène est encore démultiplié par la vitesse de propagation de l’information au sein des communautés connectées. En quelques centaines de secondes, ce sont des millions de personnes qui peuvent être informées d’une façon susceptible de modifier en profondeur leur comportement. Disposer de l’information ne suffit plus : il faut aussi anticiper ses impacts sociaux.

Poursuivre avec les technologies existantes conduirait irrémédiablement à concevoir des réseaux d’ordinateurs massivement parallèles : gigantisme et complexité de mise en œuvre en limiteraient assurément l’usage.

Les technologies du Big Data répondent précisément à cet enjeu : traiter bien plus rapidement une quantité grandissante d’informations. Là encore, cela suppose de se tourner vers une approche constructiviste.

L’exemple, à nouveau, se trouve sous nos yeux, au sein même de nos sociétés. Personne ne cherche à maîtriser parfaitement son environnement, mais chacun a conscience d’y apporter une contribution. L’équation liant la célérité et la contribution est déterminante dans la vie sociale. Apporter peu, très vite, est peu déterminant ; apporter plus, mais moins vite, c’est prendre le risque d’être devancé. Toute société vit dans cet équilibre de la compétition et de la collaboration, et c’est dans le même esprit que sont développés les algorithmes qui permettent la célérité.

Les algorithmes de célérité

Il est toujours possible d’optimiser les temps de traitement des algorithmes, mais lorsque le volume d’information croît et que, comme nous l’avons vu, les critères liés à son accès sont flous, la vitesse de traitement sera mathématiquement limitée.

Pour concevoir des algorithmes inductifs de célérité, il est nécessaire de penser autrement. L’algorithme devra être contributif et anticipatif. Pour cela l’application informatique devra s’inscrire dans un flux continu d’information et regrouper une collection d’agents chargés de transformer au plus tôt cette information en connaissance exploitable pour les instants suivants.

Cela ne va pas sans conséquence. Par exemple, en informatique décisionnelle il est d’usage de conserver l’information brute afin de conduire des traitements ultérieurs non encore déterminés. En algorithmie inductive de célérité, on préférera transformer l’information d’une forme « en extension » (exemple : conservation de tous les tickets de caisse de monsieur Dupont) vers une forme « en compréhension » (exemple : monsieur Dupont achète un pain tous les lundi et quelquefois un gâteau) plus maniable et moins volumineuse.

Autre conséquence, un algorithme de célérité sera de préférence

itératif, afin qu’on puisse le stopper sans perdre de résultats. Ainsi

l’information sera rapidement disponible et s’affinera dans un processus

continu.

Enfin, un algorithme de célérité s’inscrit dans une logique de contribution et de concurrence avec ses voisins afin d’adapter la production d’information à l’usage qui en est fait. Il dispose d’un mécanisme qui lui permet de se concentrer sur l’essentiel.

Que conclure de ce tour d’horizon ? Tout d’abord que les Big Data ne sont pas une simple question d’échelle. Les technologies qui permettent de les traiter procèdent d’un changement radical dans la façon dont on traite des données.

L’induction permet à des algorithmes de reproduire des phénomènes observés en les généralisant au-delà de leur assiette tant qu’ils demeurent efficaces, sans chercher à les modéliser. La célérité permet à des algorithmes de se concentrer sur l’essentiel afin de maintenir l’équilibre entre leur contribution et la concurrence de celle des autres. L’analyse au sein du Big Data relève ainsi clairement de l’épistémologie constructiviste : chaque système se constitue un référentiel propre qui participe au système global sans jamais connaître précisément ce dernier. Un apprentissage permanent, jamais achevé, qui produit une connaissance imparfaite mais utile. Il n’est pas interdit d’y voir une ressemblance avec le cerveau humain.

Par Jean-Pierre Malle / Directeur scientifique, Netwave / March 15th, 2013.

Enfin, un algorithme de célérité s’inscrit dans une logique de contribution et de concurrence avec ses voisins afin d’adapter la production d’information à l’usage qui en est fait. Il dispose d’un mécanisme qui lui permet de se concentrer sur l’essentiel.

Que conclure de ce tour d’horizon ? Tout d’abord que les Big Data ne sont pas une simple question d’échelle. Les technologies qui permettent de les traiter procèdent d’un changement radical dans la façon dont on traite des données.

L’induction permet à des algorithmes de reproduire des phénomènes observés en les généralisant au-delà de leur assiette tant qu’ils demeurent efficaces, sans chercher à les modéliser. La célérité permet à des algorithmes de se concentrer sur l’essentiel afin de maintenir l’équilibre entre leur contribution et la concurrence de celle des autres. L’analyse au sein du Big Data relève ainsi clairement de l’épistémologie constructiviste : chaque système se constitue un référentiel propre qui participe au système global sans jamais connaître précisément ce dernier. Un apprentissage permanent, jamais achevé, qui produit une connaissance imparfaite mais utile. Il n’est pas interdit d’y voir une ressemblance avec le cerveau humain.

Par Jean-Pierre Malle / Directeur scientifique, Netwave / March 15th, 2013.

Aucun commentaire:

Enregistrer un commentaire